Umělá inteligence dosáhla v současnosti nebývalého výkonu, ať už jde o generování textu, poskytování odpovědí, generování obrázků, videa i audia. Asistovat nám může skoro při všem co děláme, ať už jde o práci, školu nebo i při některých běžných každodenních činnostech. Přesto je její funkčnost limitována: standardní jazykové modely operují výhradně s daty, na kterých byly vytrénovány. Co však v situacích, kdy jsou vyžadovány aktuální informace, firemní dokumentace nebo přesné numerické údaje? Řešením je Retrieval-Augmented Generation (RAG).

Jak funguje Retrieval-Augmented Generation

Tato pokročilá metoda integruje generativní schopnosti jazykových modelů s vyhledáváním v externích datových zdrojích. Model tak nejen syntetizuje text, ale také aktivně vyhledává relevantní informace, které nejsou součástí jeho původního tréninkového datasetu. Díky tomu poskytuje přesnější, fakticky podložené a kontextově relevantní výstupy. RAG představuje zásadní posun v aplikaci AI – z nástroje pro kreativní podporu se stává sofistikovaný systém pro práci se znalostmi.

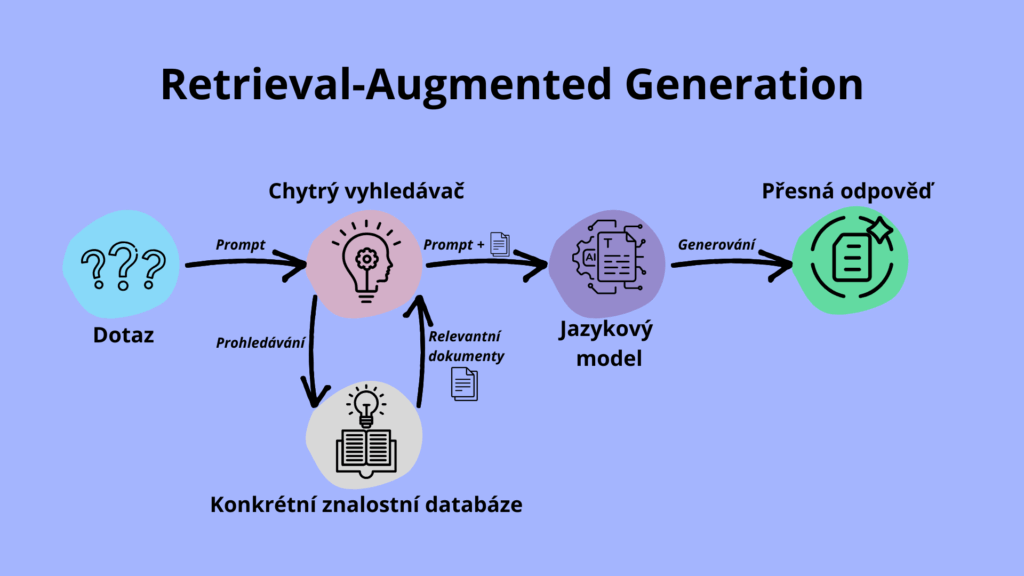

RAG (Retrieval Augmented Generation) propojuje dvě zásadní schopnosti: vyhledávání informací (retrieval) a generování odpovědí (generation). Místo toho, aby AI odpovídala jen na základě toho, co „si pamatuje“ z tréninku, dokáže si k otázce automaticky dohledat doplňující informace. Využívá k tomu např. znalostní databáze, interní dokumenty, textové soubory nebo webový obsah.

Když položíte otázku, RAG nejprve najde nejrelevantnější úryvky z připojených dat. Ty pak předá generativnímu modelu (například typu GPT), který na jejich základě sestaví srozumitelnou a přesnou odpověď. Díky tomu působí výstup přirozeně, ale zároveň je podložen aktuálními a kontextově správnými fakty.

Následující infografika ukazuje jak funguje RAG:

Skutečné využití Retrieval-Augmented Generation

Retrieval-Augmented Generation nachází uplatnění všude tam, kde potřebujeme přesné odpovědi na základě specifických informací a kde nestačí obecné znalosti AI.

Ve firmách pomáhá RAG s automatizovanou zákaznickou podporou. Místo toho, aby agent ručně procházel stovky stránek dokumentace, AI rychle najde relevantní pasáž a vytvoří odpověď, která je přirozená i fakticky správná. Podobně funguje i ve firemních znalostních systémech, zaměstnanci se, místo listování PDFek, jednoduše zeptají asistenta, který jim „vytáhne“ to podstatné.

Velký přínos má RAG i v oblasti práva, výzkumu nebo zdravotnictví, kde je potřeba rychle dohledávat přesné informace z rozsáhlých textových dat. Právník například získá souhrn aktuálních změn v legislativě, výzkumník rychlý přehled publikovaných studií a lékař může AI nechat zpracovat souhrn ze zdravotní dokumentace, vždy s důrazem na kontext a ověřitelnost.

V neposlední řadě je RAG využitelná i ve školství. Studenti si mohou nahrát své poznámky, odborné články nebo literaturu a nechat si od AI pomoci při psaní bakalářské práce nebo seminární práce. Asistent pak čerpá z jejich vlastních materiálů a nabízí návrhy, které dávají smysl a odpovídají zadání.

Výhody RAG oproti běžným AI modelům

Zatímco běžná AI (např. GPT-3.5 nebo běžné verze ChatGPT) odpovídá na základě „naučeného“ obsahu z tréninkových dat, RAG jde o krok dál. Kombinuje sílu strojového učení s aktivním vyhledáváním a umí se při odpovídání opřít o aktuální, externí informace, které si sama dohledá nebo které jí poskytnete. Klasická AI odpoví, co si „pamatuje“. RAG AI odpoví podle toho, co právě zjistí.

Tou největší výhodou je vyšší přesnost. Díky tomu, že AI pracuje s konkrétními vstupy (např. firemní dokumenty, databáze, weby), není odkázána jen na to, co „si pamatuje“. To znamená méně halucinací, tedy vymyšlených nebo zkreslených nepřesných odpovědí. Výsledkem jsou odpovědi, které dávají smysl nejen stylisticky, ale jsou i fakticky spolehlivější.

Dalším plusem je transparentnost. U RAG modelů obvykle vidíte, odkud umělá inteligence čerpala, které dokumenty použila nebo jaké úryvky citovala. Tím se zvyšuje důvěra a kontrola nad výstupy. To je důležité zejména v profesionálním prostředí, kde na výstupy AI musí být spoleh.

A konečně – Retrieval Augmented Generation umožňuje personalizaci. Když model pracuje s vašimi konkrétními daty, odpovědi jsou přesněji cílené na vaše požadavky. Díky strojovému učení se navíc dokáže přizpůsobit vašemu stylu, terminologii nebo typu obsahu, který běžně zpracováváte.

RAG vs. LLM a jak spolu vzájemně spolupracují

Jak už bylo výše nastíněno, když mluvíme o AI modelech, často narážíme na dvě základní kategorie: jazykové modely (LLM) a Retrieval Augmented Generation (RAG). Důležité je ale pochopit, že RAG není typ modelu, ale způsob, jakým je model nasazen a propojen s externími daty.

Co jsou jazykové modely (LLM)?

Large Language Models (LLM) jsou pokročilé modely, které se učí z rozsáhlých textových dat. Jejich odpovědi vycházejí z naučených vzorců, díky čemuž excelují v obecných dotazech, tvorbě kreativních textů nebo shrnutí informací. Na druhou stranu občas trpí tzv. halucinacemi, tedy mohou generovat nepřesné nebo zcela vymyšlené informace.

Populární LLM modely:

- GPT-4o, GPT-4.1, GPT-4o mini atd.

- Grok

- Claude 4 Sonnet

- Gemini 1.5 Pro, Gemini 2.0 Flash

- Mistral Large

- DeepSeek V3, DeepSeek R1

Co je Retrieval Augmented Generation a jak zvyšuje kvalitu výstupů

Retrieval Augmented Generation kombinuje LLM s nástroji pro vyhledávání relevantních dat, například ve firemních dokumentech, databázích nebo veřejných zdrojích. Výsledkem je fakticky přesnější odpověď, protože model odpovídá na základě dat, která si před odpovědí „přečte“.

RAG se s LLM propojuje v:

- Azure AI Search + GPT – Azure AI Search je cloudová služba, která indexuje vaše vlastní data (např. dokumenty, PDG, databáze) a umožňuje mezi nimi provádět inteligentní vyhledávání. Ve spojení s GPT modelem pak umožňuje generovat odpovědi na základě těchto dat.

- Google Vertex AI s Gemini – Nabízí možnost propojit jazykový model Gemini s vlastními dokumenty a databázemi v Google Cloud.

- ChatGPT s browsingem – při zapnuté funkci „prohlížeč“ dokáže ChatGPT (v placené verzi) vyhledávat v reálném čase na internetu a zahrnout do odpovědi aktuální fakta.

- OCTODEEP propojuje více velkých jazykových modelů, které jsou napojeny na RAG a nechybí ani funkce nahrávání vlastních dokumentů.

Jinými slovy RAG je architektura. Jazykové modely jsou její součástí, nikoli definicí. A právě kombinace těchto prvků umožňuje AI odpovídat přesně, věcně a s odkazem na konkrétní zdroje – což je pro firmy, analytiky i výzkumníky často klíčové.

GPT-4o, Claude nebo Gemini nejsou samy o sobě RAG modely.

Ale pokud jsou součástí systému, který využívá externí vyhledávání, pak se chovají jako RAG modely.

Aktualizováno 2. 7. 2025

Zdroje:

What is Retrieval-Augmented Generation (RAG)? | Google Cloud [online]. [cit. 02. 07. 2025]. Dostupné z: https://cloud.google.com/use-cases/retrieval-augmented-generation?hl=cs

RAG a generativní AI – Azure AI Search | Microsoft Learn [online]. [cit. 02. 07. 2025]. Dostupné z: https://learn.microsoft.com/cs-cz/azure/search/retrieval-augmented-generation-overview?tabs=docs

Vertex AI Platform | Google Cloud [online]. [cit. 02. 07. 2025]. Dostupné z: https://cloud.google.com/vertex-ai