Umělá inteligence je součástí naší společnosti a běžného života už nějakou tu dobu. Doporučuje nám hudbu, generuje texty, obrázky a dokonce i videa, je součástí automatizovaných procesů, používá se ve školství i zdravotnictví a její využití v různých pracovních odvětvích se stává stále běžnější.

AI se vyvíjí velmi rychle a tím s sebou přináší zásadní otázku týkající se etiky a morálky umělé inteligence, která stále více nabývá na naléhavosti. Tedy na jakých morálních principech by měly algoritmy stát, pokud mají sloužit lidem a ne naopak?

Etika umělé inteligence již není jen akademickým tématem pro filozofy, či právníky, ale týká se všech uživatelů a tvůrců, kteří AI používají. Kdo nese odpovědnost za osobní data svěřené AI? Na co bychom by si jako uživatelé měli při používání AI dávat pozor?

Etické otázky se, ale nevztahují jen na sféru bezpečnosti a regulace. Dotýkají se i kultury, kreativity a estetiky. AI dnes dokáže napsat básně, složit hudbu i vygenerovat fotografie, které nikdy nebyly vyfoceny, a tím narušuje samotné chápání pojmu autorství a originality.

Co je etika umělé inteligence

Etika umělé inteligence představuje soubor hodnot, zásad a pravidel, které mají řídit vývoj i používání AI systémů. Nejde však jen o právní rámec nebo souhlas s podmínkami používání. Etika v tomto kontextu nás vede k tomu, abychom přemýšleli o důsledcích ne jen o schopnostech.

Umělá inteligence není „neutrální technologie“. Ačkoli sama nemá úmysly, jedná na základě lidských rozhodnutí, ať už při návrhu, trénování, nebo implementaci. Hodnoty vývojářů, firem a institucí se tak stávají součástí samotných algoritmů.

Etika AI proto usiluje o to, aby se technologie vyvíjela směrem k respektu lidských práv, důstojnosti a rovnosti. Snaží se nastavit mantinely pro systémy, které čím dál tím víc rozhodují o našich životech, od přijetí na školu až po diagnostiku nemoci. Je nutné nastavit umělé inteligenci určité morální mantinely, které jsou založené na lidských zkušenostech a zásadách.

Obrázek vygenerovaný modelem GPT-1-Image přes aplikaci OCTODEEP.

Hlavní etické výzvy

Etika umělé inteligence zahrnuje celou škálu hodnot, které se promítají do toho jak je AI navrhována, trénována a používána. Většina organizací, včetně Evropské komise nebo technologických firem definují klíčové etické principy, které by měly vývoj umělé inteligence rámcovat. Nicméně stále jsou určitá slepá místa,

Kdo nese odpovědnost?

Pokud AI způsobí chybu, kdo za ni nese odpovědnost? Lze vinit tvůrce algoritmu, firmu, která jej nasadila, nebo uživatele a jeho způsob jakým jej použil? V současnosti je odpovědnost často rozostřená, což znesnadňuje nápravu škod i posílení důvěry v technologie.

Například: Firma nasadí chatbot pro klientské poradenství v bance. Chatbot omylem poradí zákazníkovi investici, která vede k výrazné ztrátě. Banka se odvolává na to, že šlo o „automatizovaný systém“, ale klient chce náhradu. Kdo je viník – vývojář, nebo banka?

Férovost a předpojatost

Jak už jsme zmínili výše, odpovědnost je jednou ze sfér ve kterých si etika AI není úplně jistá. Dalším takovým slepým místem je férovost a předpojatost, a to především vzhledem k tomu, že se AI modely učí z dat, která odrážejí realitu, jenže realita bývá v určitých ohledech často předpojatá. To může vést k neúmyslné diskriminaci na základě pohlaví, etnicity nebo věku.

Například: Online náborový nástroj vyřazuje životopisy uchazeček o IT pozici, protože model byl trénovaný na historických datech, kde převažovali muži. Uchazečky nedostanou šanci jen kvůli tomu, že je algoritmus „naučen“ vnímat ženské životopisy jako méně vhodné.

Transparentnost

AI modely často fungují jako tzv. black box, to znamená, že dávají výstupy, ale není snadné pochopit, jak k nim dospěly.

Například: Studentka je automaticky zamítnuta při přihlášce na prestižní školu. Škola se odvolává na výběrový algoritmus, ale není schopna vysvětlit, proč byla konkrétní žádost zamítnuta. Rozhodnutí je neprůhledné a pro studentku neodvolatelné.

Lidský dohled a autonomie

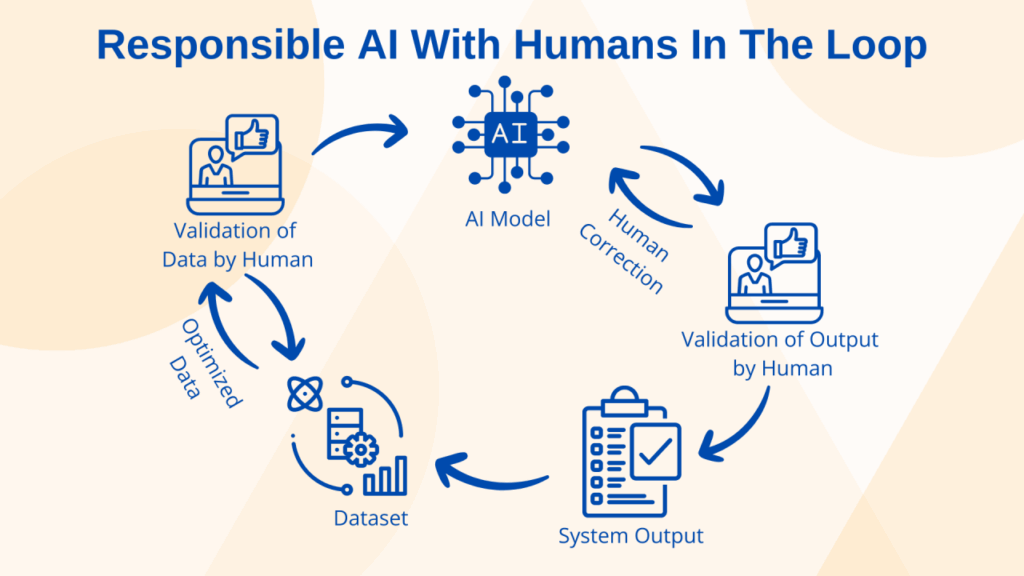

AI by neměla nahrazovat člověka tam, kde je rozhodnutí existenčně citlivé, například v některých oblastech zdravotnictví, justici nebo sociální péči. Hovoří se o principu „člověka ve smyčce“ (human-in-the-loop), který zajišťuje, že klíčová rozhodnutí nepřenecháme výhradně strojům.

Infografika vysvětlující princip Human-in-the-loop.

Například: V soudnictví je zaveden algoritmus, který doporučuje výši kauce na základě minulého chování obžalovaných. Systém označí mladého muže z menšiny za „vysoké riziko útěku“, ačkoliv má stálé bydliště i práci. Soudce, pod tlakem rychlosti a přetížení systému, bez hlubšího přezkoumání verdikt přijímá. Rozhodnutí působí neutrálně, ale ve skutečnosti posiluje systémové nerovnosti.

Soukromí a ochrana dat

Modely trénované na rozsáhlých datech mohou neúmyslně uchovávat citlivé informace. Je nutné, aby AI věděla jak zacházet s osobními údaji eticky a bezpečně.

Například: Aplikace na úpravu fotografií využívá AI, ale bez vědomí uživatelů ukládá a analyzuje jejich tváře k trénování jiného modelu. Jeden z uživatelů později narazí na generovaný obrázek osoby, která se mu až nepříjemně podobá – a nikdy nedal souhlas k takovému použití.

Bezpečnost a použití

Zneužití zahrnuje deepfakes, automatické šíření dezinformací a s tím spojenou manipulaci s veřejným míněním.

Například: Politická kampaň využije AI model k cílení personalizovaných zpráv na sociálních sítích. Pomocí analýzy dat vytvoří stovky různých verzí příspěvků – od umírněných po konspiračně laděné – a rozesílá je různým skupinám podle jejich emocí, obav a přesvědčení. Lidé tak dostávají zcela odlišný obraz téhož kandidáta, což oslabuje možnost veřejné debaty i informovaného rozhodování.

Udržitelnost

Trénink velkých jazykových modelů spotřebovává obrovské množství energie a vyžaduje servery po celém světě.

Například: Startup trénuje vlastní jazykový model, který je však neefektivní a energeticky náročný. Spotřebuje během dvou týdnů tolik elektřiny jako stovky domácností za celý rok. Výsledek přitom nepřináší zásadní novinku oproti existujícím modelům – šlo pouze o PR.

Jestliže vás zajímá jaké vyhlídky nás čekají s dalším vývojem umělé inteligence, můžete se podívat na náš článek Jaká nás čeká budoucnost s umělou inteligencí?

Jak přední vývojáři přistupují k etice a bezpečnosti

Etické otázky nejsou jen teoretickou debatou, každá společnost vyvíjející umělou inteligenci přistupuje ke své technologii jinak. Liší se nejen filozofií vývoje, ale i tím, jak chrání uživatele, jak transparentní jsou jejich modely a co považují za přijatelné použití.

OpenAI

Společnost OpenAI, která vyvinula ChatGPT a jeho verze např. GPT-4.1, GPT-4 GPT-4o, GPT-4o mini, GPT-3.5, GPT-3 nebo pokud jde o AI generování obrázků, tak grafický model integrovaný přímo do chatu GPT 1 Image. OpenAI ve svých modelech uplatňuje přísné Usage Policies, které zakazují využití k podvodům, šíření nenávisti,, dezinformací nebo manipulaci. Důraz klade na bezpečnostní testování modelů a vytváření bezpečnostních rámců jako je „Safety Advisory Group“. Odpovědnost řeší i interně, konkrétně zavedením anonymního kanálu pro hlášení etických problémů. Pracuje v souladu s GDPR a prokazatelně splňuje standardy bezpečnosti dat.

Anthropic (Claude)

Společnost Claude, která vyvinula modely Claude 3.5 Sonnet, Claude 3.7 Sonnet a Claude 4. Všechny Claude modely obsahují vestavěná etická pravidla (Constitutional AI), která zamezují škodlivým nebo klamavým výstupům, a to jak u textu, tak u obrazů . Anthropic transparentně zveřejňuje své principy, system cards i ISO 42001 certifikaci pro bezpečný vývoj AI.

Google DeepMind (Gemini + Imagen)

Společnost Google DeepMind a její modely z řady Gemini např. Gemini 2.0 Flash, Gemini 2.0 Flash-Lite a Gemini 1.5 Pro včetně jejich ai generátoru obrázků Imagen (text-to-image diffusion)

Google říká, že modely jako Gemini a Imagen prochází ethical pre‑launch reviews, používají bezpečnostní filtry pro detekci manipulace a u obrázků implementují metadata označující AI tvorbu . Imagen navíc varuje před možnou nepravdivostí vizuálních výstupů a podporuje označení metadat.

DeepSeek

Společnost DeepSeek, která vytvořila modely jako například DeepSeek R1, DeepSeek V3, se oficiálně hlásí k závazku o transparentnosti a zodpovědnosti, nicméně italský regulátor varuje před nedostatečnou ochranou proti halucinacím, tedy falešnému či fakticky nesprávnému obsahu. Objevují se také obavy ohledně cenzury a státní regulace.

Mistral AI

Evropská společnost Mistral AI, která má na kontě například model Mistral Large, jde cestou otevřeného přístupu a deklarované podpory EU AI Act. Zveřejňuje etický kodex a klade důraz na bezpečnost a partnerský přístup k institucím.

Grok (xAI)

Společnost Elona Muska xAI, která vytvořila AI model Grok, který je součástí platformy X, nemá žádný veřejně dostupný etický rámec, ale reagovala na několik kontroverzí, týkajících se generování násilného nebo pornografického deepfake obsahu. XAI slíbilo větší transparentnost například zveřejněním systémových promptů a omezením impersonace Elona Muska, nicméně stále čelí kritice kvůli slabým moderátorským opatřením.

Stable Diffusion (StabilityAI)

Stable Diffusion je open‑source model určený pro generování obrázků, uvolněný pod licencí Creative ML OpenRAIL-M, která zdůrazňuje odpovědné a legální používání. Společnost Stability AI implementuje etické filtry a varování uživatelům, aby se model nepoužíval k nelegálním deepfake nebo pornografickým účelům.

| Společnost | Modely | Etický rámec / zásady |

| OpenAI | GPT‑4.1, GPT‑4o, GPT‑3.5 | Usage Policies, red teaming, GDPR, SOC2, filtr škodlivého obsahu |

| Anthropic | Claude 3 Opus, Sonnet, Haiku | Constitutional AI (ústava modelu), ISO 42001, prevence škodlivých výstupů |

| Google DeepMind | Gemini 1.5 Pro, Flash, Flash Lite | AI Principles, etické audity, kontrola biasu, Privacy Hub |

| DeepSeek | DeepSeek V2, Coder, Math, Chat | Obecný závazek k transparentnosti, ale chybí veřejný formální kodex |

| Mistral AI | Mistral 7B, Mixtral 8x7B, Mistral Large | Kodex integrity, podpora AI Act, otevřenost, evropská etická orientace |

| xAI | Grok 1, 1.5, 2, 3(textové modely) | Slib zveřejnění systémových promptů, zatím slabší moderace |

Bezpečnost a etika v OCTODEEP

Všechny výše uvedené jazykové modely jsou dostupné v aplikaci OCTODEEP, která je agreguje do jednoho rozhraní. Patří sem modely OpenAI (GPT‑4.1, GPT‑4.1 Mini, GPT‑4.1 Nano, GPT‑4o, GPT‑4o Mini, GPT‑o4 Mini, GPT‑o1 Mini), xAI (Grok 3, Grok 3 Mini), Anthropic (Claude 4 Sonnet, Claude 3.7 Sonnet, Claude 3.5 Sonnet), Google DeepMind (Gemini 2.0 Flash, Gemini 2.0 Flash‑Lite, Gemini 1.5 Pro), Mistral AI (Mistral Large, Mistral Medium) a DeepSeek (DeepSeek V3).

Při jejich používání v rámci OCTODEEP se automaticky uplatňují bezpečnostní podmínky a etické zásady stanovené konkrétními vývojáři. Aplikace do samotné logiky modelů nezasahuje, ale zajišťuje, že každý model je provozován v souladu s pravidly pro prevenci škodlivého, klamného nebo nelegálního obsahu. Díky tomu je možné pracovat s různými výkonnými nástroji v bezpečném a odpovědném prostředí a zároveň využívat jejich různorodost podle konkrétního účelu: psaní, výzkum, kódování či konverzaci.

Etika AI generovaného umění

Tvorba pomocí umělé inteligence zásadně proměňuje pojetí umění, autorství i originality. Zatímco ještě donedávna byla umělecká činnosti spojena výhradně s lidskou invencí, dnes je možné během několika vteřin vygenerovat obraz, báseň nebo hudební skladbu bez fyzického lidského zásahu. Tento posun s sebou přináší otázky, které se týkají samotné podstaty umělecké tvorby: Kdo je autorem? Lze mluvit o originalitě, pokud je výstup výsledkem statického výpočtu? A jak rozlišovat mezi inspirací a napodobováním?

Velkou pozornost si zaslouží otázka trénovacích dat. Většina generativních modelů je „učena“ na obrovském množství vizuálních, textových nebo zvukových materiálů, které pocházejí z internetu, a to často bez souhlasu původních tvůrců. Tyto datové sady obsahují i autorsky chráněná díla, jejichž fragmenty či stylové znaky se následně mohou objevovat ve výstupech AI. To vyvolává etické napětí mezi technologickým pokrokem a respektováním práv tvůrců.

Zvláštní kapitolu tvoří otázka kulturní citlivosti. Styl, forma či estetika nejsou hodnotově neutrální, ale nesou s sebou kulturní, historické a ideové významy. Pokud AI napodobuje určité tradice bez porozumění jejich kontextu, může vzniknout efekt kulturní apropriace, která vyprazdňuje původní význam a zplošťuje obsah do vizuálního klišé. Umělecký výstup pak sice působí atraktivně, ale zároveň může být neeticky zjednodušující.

S generativní AI je spojeno i riziko manipulace a zneužití. AI umění může být použito k vytváření falešných obrazů, identit či událostí, aniž by bylo na první pohled zřejmé, že jde o fikci. Zvláště v případě realisticky působících výstupů je těžké rozlišit, co bylo tvořeno lidskou zkušeností a co algoritmem. Tím se rozostřuje hranice mezi tvůrčím vyjádřením a syntetickou simulací.

Dalším etickým tématem je otázka transparentnosti. Předmětem diskuze je, zda, kdy a jak označovat, že dílo vzniklo pomocí AI. Zatímco v některých oblastech je součinnost člověka a algoritmu běžná a otevřeně přiznávaná, jinde se zamlčuje, a to může vést k dezinterpretaci či ztrátě důvěry ze strany publika.

Nakonec se proměňuje i samotná role umělce. Místo přímého „tvůrce“ se člověk často stává tím, kdo zadává, vybírá, upravuje a kurátoruje. Tvorba se přesouvá od manuálního výkonu ke schopnosti koncipovat, rozhodovat a interpretovat. I tento posun má etický rozměr, redefinuje vztah mezi člověkem a strojem, mezi záměrem a výsledkem, mezi řemeslem a vizí.

Obrázek vygenerovaný modelem GPT-1-Image přes aplikaci OCTODEEP.

Aktualizováno: 18. 6. 2025

Zdroje:

Security and Privacy [online]. [cit. 18. 06. 2025]. Dostupné z: https://openai.com/security-and-privacy/?utm_source=chatgpt.com

Safety Guidelines [online]. [cit. 18. 06. 2025]. Dostupné z: https://openai.com/safety/?utm_source=chatgpt.com

Anthropic achieves ISO 42001 certification for responsible AI \ Anthropic [online]. [cit. 18. 06. 2025]. Dostupné z: https://www.anthropic.com/news/anthropic-achieves-iso-42001-certification-for-responsible-ai?utm_source=chatgpt.com

DeepSeek Safety Guidelines [online]. [cit. 18. 06. 2025]. Dostupné z: https://milvus.io/ai-quick-reference/what-ethical-guidelines-does-deepseek-follow-in-ai-research?utm_source=chatgpt.com

EU AI Act: first regulation on artificial intelligence | Topics | European Parliament [online]. [cit. 18. 06. 2025]. Dostupné z: https://www.europarl.europa.eu/topics/en/article/20230601STO93804/eu-ai-act-first-regulation-on-artificial-intelligence

Elon Musk’s AI company says Grok chatbot focus on South Africa’s racial politics was ‚unauthorized‘ | AP News [online]. [cit. 18. 06. 2025]. Dostupné z: https://apnews.com/article/grok-ai-south-africa-64ce5f240061ca0b88d5af4c424e1f3b

StabilityAI Safety [online]. [cit. 18. 06. 2025]. Dostupné z: https://stability.ai/safety

Etika umělé inteligence — Knihovna plus [online]. [cit. 18. 06. 2025]. Dostupné z: https://knihovnaplus.nkp.cz/archiv/2024-02/informace-a-konference/etika-umele-inteligence

Etika umělé inteligence [online]. [cit. 18. 06. 2025]. Dostupné z: https://www.sap.com/cz/resources/what-is-ai-ethics#p%C5%99%C3%ADpady-pou%C5%BEit%C3%AD-etiky-um%C4%9Bl%C3%A9-inteligence-pro-r%C5%AFzn%C3%A9-role-v-organizaci