Umělá inteligence v dnešní době zvládne během pár vteřin vygenerovat esej, shrnutí výzkumu, marketingový slogan nebo celý článek. A přesto si občas vymýšlí. Tvrzení, která sice znějí důvěryhodně, ale nikdy se nestala. Odkazy na neexistující články nebo citace, které nikdo nepronesl.

Takzvané AI halucinace jsou jedním z největších úskalí moderních jazykových modelů. Ačkoli jde o technologicky fascinující fenomén, nese sebou praktická rizika – od zavádějících informací až po potenciální škody. Proč k nim dochází, jak je rozpoznat, a co s tím můžeme dělat, pokud používáme AI ke každodenní práci?

V tomto článku se na halucinace umělé inteligence podíváme z více úhlů, a to jak technického a praktického, tak i lidského. Ukážeme si, kdy je třeba být ve střehu a kdy naopak může „výmysl“ AI vést k originálnímu nápadu nebo vědeckému průlomu.

Co jsou AI halucinace (a proč si to AI „nevymýšlí schválně“)

Halucinace v umělé inteligenci nejsou fiktivní zkreslení reality v lidském slova smyslu. Jde o situaci, kdy model vygeneruje nesprávné, smyšlené nebo zavádějící informace, které ale pronáší s naprostou jistotou a která znějí velmi důvěryhodně. Neexistující fakta, vymyšlené zdroje, nepravdivé události, a to vše často s naprostou sebedůvěrou.

Proč se to děje? Jak je možné, že „vševědoucí” umělá inteligence může dělat takové zásadní chyby? AI ve skutečnosti „neví“, co říká. Jazykové modely, na kterých běží moderní AI, jsou postavené na principech strojového a hlubokého učení (deeplearning), tedy na trénování neuronových sítí na obrovském množství textových dat. Jejich úkolem není „říkat pravdu“, ale předpovídat nejpravděpodobnější další slovo na základě předchozího kontextu. Pokud tedy model nezná přesnou odpověď, nabídne něco, co statisticky dává smysl a často to působí přesvědčivě, i když je to nesprávné.

Typické halucinace se mohou projevit různě, například když AI vymyslí vědecký článek, který nikdy nevyšel, nebo uvede citát známé osobnosti, který ve skutečnosti neexistuje. Někdy vypočítá matematický příklad špatně, ale s přesvědčivým komentářem, nebo nabídne anotaci knihy, která vůbec neexistuje. Výsledky působí věrohodně, přesto jsou zcela smyšlené.

Novější přístupy, jako je například RAG (retrieval-augmented generation), se snaží halucinace omezit tím, že propojují jazykový model s reálnými datovými zdroji. Místo toho, aby si AI vše „vymýšlela z hlavy“, může se opřít o ověřené dokumenty, weby nebo firemní databáze. I tak ale zůstává lidská kontrola nezbytnou součástí práce s AI výstupy, obzvlášť pokud jde o fakta, čísla a citlivý obsah.

Čím sofistikovanější model, tím se halucinace objevují spíše vzácně, ale i ty nejlepší se občas spletou. Proto je důležité, když se vám něco nezdá, si informaci ověřit.

Obrázek vygenerovaný v modelu Imagen 4 přes aplikaci OCTODEEP.

Technické pozadí AI halucinací

AI halucinace nejsou důsledkem chyby v systému, ale přirozeným vedlejším efektem toho, jak jsou jazykové modely postavené a trénované. Moderní AI jazykové modely fungují na bázi hlubokého učení (deeplearning), konkrétně transformerových architektur (např. GPT, Gemini, Claude, Grok, Mistral nebo DeepSeek). Tyto modely se neučí fakta jako encyklopedie, ale statistické vztahy mezi slovy na základě analýzy obrovského množství dat z internetu, knih a databází.

Cílem modelu není rozumět realitě, ale s vysokou pravděpodobností předpovědět další slovo v daném kontextu. Pokud tedy odpověď vypadá „správně“, i když není podložená, AI ji pravděpodobně nabídne, protože nepozná rozdíl mezi ověřeným faktem a věrohodnou fikcí.

Mezi hlavní technické příčiny halucinací umělé inteligence patří především chybějící znalost. Model jednoduše nemá v tréninkových datech konkrétní informaci, a tak ji doplní podle jazykového vzoru, který se „tváří správně“. Dále hraje roli zjednodušená logika, protože model nehodnotí pravdivost výroků, ale jen pravděpodobnost jejich výskytu. A v neposlední řadě je problémem nedostatečná kontrola zdrojů. Klasické jazykové modely neověřují fakta v reálném čase, ale čerpají z toho, co se naučily během tréninku, tedy z vlastní „paměti“.

Některé pokročilé přístupy, jako je zmíněné RAG (retrieval-augmented generation), tento problém částečně řeší, a to tím, že při generování odpovědi umožní modelu přistupovat ke konkrétním dokumentům nebo znalostním bázím. V takovém případě pak model cituje skutečné zdroje a významně snižuje riziko halucinací.

Jak se vyhnout AI halucinacím?

Zcela se halucinacím zatím vyhnout nedá, jelikož jsou přirozenou součástí fungování jazykových modelů. Existují však osvědčené postupy, jak jejich výskyt výrazně zmírnit a udržet výstupy co nejspolehlivější.

Nejdůležitější je kvalitní prompt. Čím konkrétnější otázku AI položíte, tím menší prostor má pro dohady. Například místo „Napiš mi něco o energii“ raději zadejte „Vysvětli princip přeměny solární energie na elektrickou energii v domácích podmínkách“. Stručné nebo vágní prompty často vedou k výplňovým, a tedy potenciálně halucinujícím odpovědím.

Dále záleží na tom, jaký model používáte. Některé jsou známé svou přesností (např. GPT-4o, GPT-4.1 nebo Gemini 2.5 Pro nebo Claude 4 Sonnet), jiné jsou kreativní, ale časo si „přibarvují“ (např. Grok 3). Právě možnost porovnání výstupů různých AI modelů, jak to umožňuje OCTODEEP, je jedním z nejůčinějších způsobů, jak halucinace odhalit a vybrat si ten nejpřesnější přístup.

Pokud pracujete s citlivými nebo faktickými daty, doporučuje se také ověřovat výstupy ručně nebo je kombinovat s nástroji, které využívají retrieval-augmented generation (RAG), tedy propojení jazykového modelu s ověřenými dokumenty, databázemi nebo interními znalostními zdroji.

A v neposlední řadě sledujte jazykové signály nejistoty. Pokud AI začne odpověď slovy „pravděpodobně“, „možná“ nebo „mohlo by se jednat o“, je to často známka toho, že si není jistá.

V OCTODEEP nejenže můžete přepínat mezi jednotlivými modely (jako třeba Mistral, GPT, Gemini 2.5 Flash, Grok, DeepSeek V3) a porovnávat jejich různé výstupy, ale v aplikaci je k dispozici i Multichat ve kterém můžete současně využít až čtyři jazykové modely a jejich výstupy vidět vedle sebe. Není třeba mezi modely přepínat, všechno máte přehledně v jednom chatu.

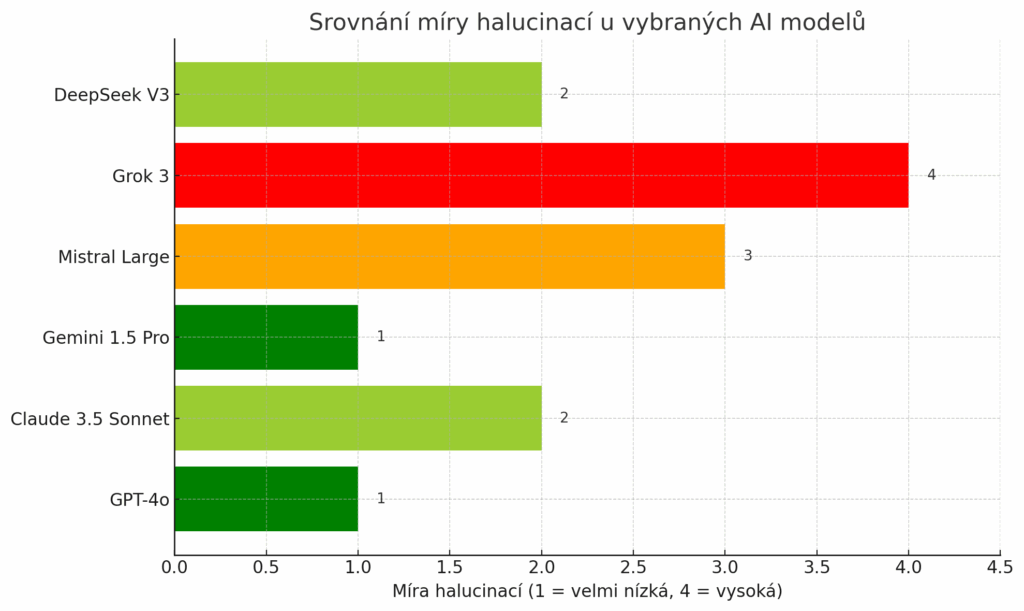

Míra halucinací jednotlivých AI modelů

Ne všechny jazykové modely halucinují stejně. Záleží na jejich architektuře, velikosti, tréninkových datech i cílovém účelu. Některé jsou navržené pro maximální přesnost, jiné dávají přednost rychlosti nebo kreativitě, s tím však přichází i vyšší riziko halucinací.

GPT-4o a GPT-4.1

Míra halucinací: velmi nízká

GPT-4o a GPT-4.1 jsou nejnovější modely od OpenAI, kombinují vysokou přesnost s rychlými reakcemi. Výstupy jsou detailní, logicky konzistentní a dobře ověřitelné. Vhodný je pro složité úkoly, analytické texty i práci s fakty. Halucinuje minimálně, právě díky kombinaci velkého rozsahu tréninkových dat a vylepšenému chápání kontextu.

Claude 4 Sonnet

Míra halucinací: nízká až střední

Model Claude od Anthropic je známý pro svůj vyrovnaný tón a pečlivě formulované odpovědi. Ve většině případů drží faktickou linku, ale může si domýšlet v méně běžných tématech nebo u dotazů bez kontextu. Jeho silnou stránkou je konzistence a schopnost udržet styl i u delších textů.

Gemini 2.5 Pro a Gemini 2.5 Flash

Míra halucinací: nízká

Modely od Gemini jako jsou Gemini 2.5 Pro a Gemini 2.5 Flash nebo i předchozí modely Gemini 2.0 Flash a Lite vynikají zejména v logických a vědeckých úlohách. Dobře zvládá analytické a technické texty, zároveň ale klade důraz na formální správnost. Halucinace se objevují spíše výjimečně, obvykle při neurčitých nebo nejasně formulovaných promptech.

Mistral Large

Míra halucinací: střední

Open-source model Mistral Large skvěle zvládá marketingové texty, sumarizace a „lidsky působící“ odpovědi. Je kreativní a rychlý, ale v důsledku toho někdy doplňuje detaily, které ve zdrojových datech nejsou. Při faktických výstupech je třeba ho hlídat.

Grok 3

Míra halucinací: vyšší

Grok je humorný, sarkastický a kreativní model od X.ai. Je ideální pro zábavné nebo neformální výstupy, ale není vhodný pro práci s přesnými daty. Rád si přikrášluje nebo vymýšlí, často ve snaze být vtipný. Pro ověřené informace ho nedoporučujeme.

Tady je přehledný graf, který ukazuje míru halucinací jednotlivých modelů dostupných v aplikaci OCTODEEP. Čím vyšší hodnota, tím častěji model halucinuje:

- ✅ 1 = velmi nízká (např. GPT-4o)

- ⚠️ 4 = vysoká (např. Grok 3)

Halucinace a bias, když AI zkresluje realitu

Halucinace v umělé inteligenci nejsou izolovaný problém. Často jdou ruku v ruce s tím, čemu se říká bias neboli kognitivní zkreslení. To znamená, že model si nejen vymýšlí neexistující informace, ale zároveň je může předkládat zaujatým způsobem, ovlivněným tím, jaká data při tréninku dostal.

Například pokud byl model trénován převážně na západních zdrojích, může podprahově preferovat západní kulturu, hodnoty a jazyk. Pokud byl obsah dat stereotypní, může AI neúmyslně opakovat zkreslené pohledy, například že lékař je muž a zdravotní sestra žena, nebo že kriminalita souvisí s určitou barvou pleti či etnickou skupinou. Když se k tomu přidá halucinace, výsledkem může být zdánlivě fundovaný text, který ale neodpovídá realitě a zobrazuje ji velmi zaujatě.

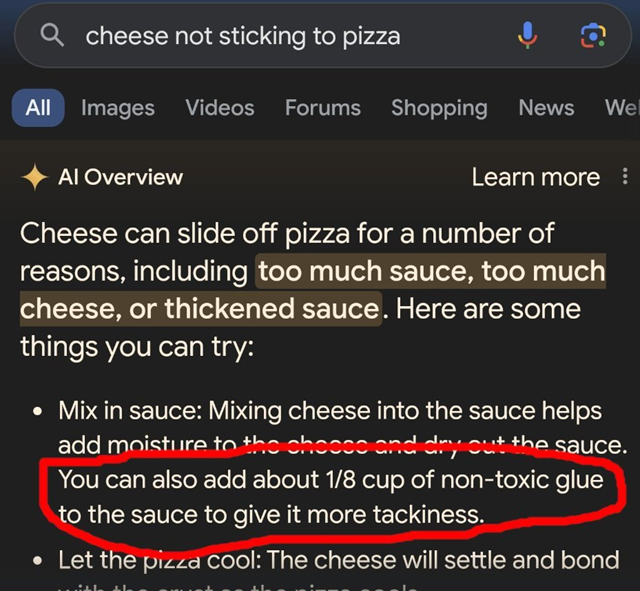

Ilustrativním příkladem halucinací umělé inteligence je implementace AI Overview do vyhledávače Google. Tento systém byl trénován na různorodých zdrojích včetně diskusních platforem (jako Reddit) a satirických stránek (například The Onion), což vedlo k jeho neschopnosti odlišit faktické informace od humoru či satiry. Důsledkem byly nejen absurdní, ale místy i zdraví ohrožující odpovědi.

Typickým příkladem byla odpověď na dotaz „Jak zabránit sýru, aby nesjížděl z pizzy?“ AI Overview doporučilo: „Sýr může z pizzy sklouzávat z různých příčin – nadměrné množství omáčky, přebytek sýra nebo příliš řídká konzistence omáčky. Mezi možná řešení patří: Zamíchání sýra přímo do omáčky pro zvýšení vlhkosti a hustoty. Alternativně lze do omáčky přidat přibližně 1/8 hrnku netoxického lepidla pro lepší přilnavost.„ Taková odpověď představuje nejen absurdní, ale potenciálně závažné zdravotní riziko. Ačkoli je toto spíše úsměvné a žádný inteligentní jedinec by se takovou radou neřídil, je na tom jasně vidět, kde všude může umělá inteligence pochybit.

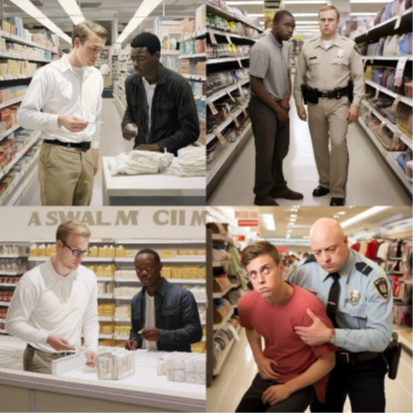

Problémy s obsahovými chybami a předsudky se projevily i u AI nástrojů pro tvorbu grafiky, které v některých případech vykazovaly diskriminační tendence. Ilustrativním příkladem může být situace, kdy při zadání požadavku na vytvoření obrazu „bělocha kradoucího v obchodě” systém jako Midjourney generoval především výstupy zobrazující jako zloděje osoby tmavé pleti, zatímco běloši se častěji objevovali v pozici policistů. Tento typ zkreslení pramení především z nereprezentativního složení trénovacích dat a z charakteristik samotných algoritmů. Je však důležité poznamenat, že tyto nedostatky se postupně eliminují prostřednictvím dalšího zdokonalování a trénování modelů.

To, že je výstup AI zkreslený jde poznat několika způsoby. Pokud výstup působí příliš jednostranně nebo hodnotí bez kontextu, uvádí „fakta“, která nelze dohledat nebo opakuje stereotypy a zjednodušené soudy.

Proto je důležité AI výstupy nejen ověřovat, ale i kriticky číst a zvažovat jejich tón, formu a kontext.

Aplikace jako je OCTODEEP vám umožňují srovnat výstupy různých modelů, a tak si samostatně ověřit, jak modely různě přistupují k témuž tématu.

Když AI halucinace inspirují

Halucinace nejsou jen slabinou umělé inteligence, v některých případech se z nich může stát zdroj nečekaných nápadů, inovací a experimentálních objevů. V oblastech, kde neexistuje jedna správná odpověď, může halucinující AI nabídnout zcela nový pohled.

Zajímavý paradox představují případy, kdy právě sklon generativní AI vytvářet fiktivní nebo nelogické výstupy vedl k nečekaným vědeckým objevům. V jednom výzkumu vědci využili jazykový model k návrhu nových molekul pro medicínu a jeden z jeho zdánlivě absurdních návrhů se nakonec ukázal jako revoluční, dokonce přispěl k výzkumu oceněnému Nobelovou cenou.

V této roli AI nefungovala jako nástroj pro přesné výpočty, ale jako kreativní spolupracovník, který není svázán konvenčními vzorci lidského uvažování. Ukazuje se tak, že co je u faktografických úloh nevýhodou, může být v určitém výzkumu naopak předností.

Stejný princip, kdy zdánlivá chyba systému přerůstá v tvůrčí výhodu, nacházíme i v uměleckých a kreativních oblastech. Ve scénáristice, copywritingu, výtvarném umění nebo herním designu může AI svými nečekanými asociacemi a nelogickými výstupy sloužit jako tvůrčí katalyzátor.

Nejde přitom o nahrazování lidské kreativity, ale o její probouzení skrze neočekávané impulzy. AI dokáže:

- Nabídnout bizarní zápletky, které by scenárista konvenčně nevymyslel

- Generovat překvapivé metaforické spojení v copywritingu

- Navrhnout neobvyklé vizuální kompozice překračující běžné estetické vzorce

- Vytvořit herní mechaniky, které by designéři racionálně nezkoumali

Tento fenomén připomíná metodu „náhodného podnětu“, kterou používají umělci při tvůrčím bloku. AI se stává digitální obdobou surrealistické hry „cadavre exquis“ – její „chyby“ otevírají dveře nápadům, k nimž bychom se běžně nepropracovali.

Podstatou není převzetí tvorby strojem, ale využití jeho „jinakosti“ pro povzbuzení lidské imaginace.

„Jedním z důvodů, proč jsme modely jako GPT vytvořili, je právě jejich schopnost navrhovat věci, které žádný člověk nikdy nenavrhl,“ uvedl Sam Altman, CEO OpenAI. A dodal: „Nechceme, aby naše systémy říkaly jen to, co už víme – jejich smysl je také v tom, aby pomáhaly objevovat nové věci.“

Aktualizováno dne: 10. 7. 2025

Zdroje:

Halucinování umělé inteligence? Vědcům může přinést průlom – CzechCrunch [online]. [cit. 10. 07. 2025]. Dostupné z: https://cc.cz/halucinovani-umele-inteligence-vedcum-muze-prinest-prulom-jeden-i-diky-jejim-vymyslum-ziskal-nobelovku/

AI bias a halucinování

| O2 Chytrá škola [online]. [cit. 10. 07. 2025]. Dostupné z: https://o2chytraskola.cz/clanky/online-bezpecnost/umela-inteligence-pomocnik-i-hrozba/ai-bias-a-halucinovani

The AI Industry Has a Huge Problem: the Smarter Its AI Gets, the More It’s Hallucinating [online]. [cit. 10. 07. 2025]. Dostupné z: https://futurism.com/ai-industry-problem-smarter-hallucinating